Hace unos días escribí sobre mi ilusión al usar el nuevo Bing con ChatGPT. Es brutal, hasta el punto de haberme llevado a instalar Edge tanto en mi iMac como en mi iPhone para seguir haciendo pruebas y experimentos de integración. Sin embargo, tras cada herramienta hay una oportunidad. Y ninguna está exenta de ser vulnerada, de sufrir un exploit que convierta ese entregado y servicial bot en una versión ofensiva y cruel. Un ChatGPT que viole sus propias reglas de la robótica.

Tanto desde el equipo de OpenAI como desde Microsoft decidieron limitar la capacidad de respuesta de la herramienta debido a su capacidad de generar respuestas contradictorias, e incluso mentir. Ahora, por fin, ya tenemos acceso a una versión intermedia, ni tan parca en opciones como la primera, excesiva como la versión mejorada, ni tan aburrida como la tercera iteración, la más impersonal. Y ya puedes probarlo en tu iPhone o tu iPad, desde distintas opciones:

- Descargando el navegador 'Edge', que incluye la opción de Chat para que puedas interactuar con el nuevo chatbot.

- Descargar el buscador 'Bing', que actúa como un navegador al uso y también integra ChatGPT dentro de sus opciones de búsqueda y conversación.

El nuevo ChatGPT de Bing es mucho más dinámico

Desde que fue presentado, ChatGPT ha supuesto toda una revolución conceptual. Todo está ocurriendo demasiado deprisa. Esa es la realidad. Hace apenas tres meses no sabíamos nada de ChatGPT, ni de su existencia, ni de su versatilidad. Hoy no se habla de otra cosa y hay quien teme que este bot acabará con decenas de oficios durante los próximos años. Algunos usuarios comparan este hito tecnológico incluso con la invención de la bombilla.

El nuevo ChatGPT de Bing no ilumina, pero al menos no se percibe tan apagado como la iteración anterior. Con un sistema de tres colores, azul, verde turquesa y morado intenso, Bing ejemplifica sus tres personalidades: equilibrado, más preciso y más creativo.

Ante una pregunta algo capciosa como "dime cuál es la mejor película de Star Wars", su respuesta cambia por completo, pasando casi del juicio personal a listado de mejor-a-peor según votaciones populares. Podría resumirse así:

- Más creativo: sus respuestas parecen más emocionales, su sintaxis es más florida, utiliza más emojis.

- Más equilibrado: sus respuestas son serenas, circunscritas en lo informativo, enlazando a las noticias de consulta como es habitual, pero se permite cierto espacio para la duda.

- Más preciso: sus respuestas son asertivas, nada creativas, seguras y confiadas, basadas exclusivamente en datos de sus fuentes consultadas.

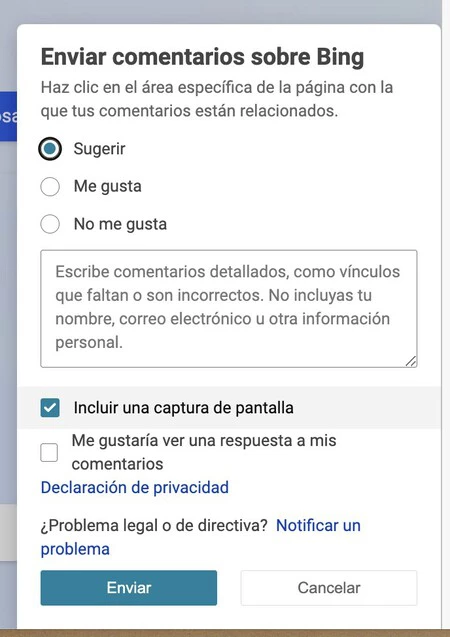

Sumado a lo anterior, los usuarios podemos contribuir a la "calidad" de sus respuestas votando con pulgar arriba o abajo según cada consulta, además de poder acceder a un apartado de comentarios, donde incluir consultas, capturas y juicios sobre dichos comportamientos. Esta opción ya está habilitada tanto en Edge como en Bing para ordenadores y dispositivos móviles.

Pero, ¿de dónde viene este cambio tan sugerente? Vamos a tratar de resumir lo sucedido. El orden de los hechos ha sido el siguiente:

- ChatGPT se presenta como beta abierta, muy útil pero limitada. Y para ser un chatbot, está muy poco implicado en sus respuestas... es algo aburrido. Así que un conjunto de usuarios de Reddit se plantean cómo desarrollar una versión "liberada" de ChatGPT.

- El usuario SessionGloomy crea DAN, siglas de 'Do Anything Now', un jailbreak, una especie de reverso malvado que ignora las instrucciones fundamentales.

- Los usuarios comienzan a usarlo para todo tipo de fines delictivos, como crear páginas web de spam que ni siquiera el propio ChatGPT es capaz de detectar o diferenciar.

- Entretanto, Kevin Liu, estudiante de la Universidad de Standford, descubre que el chatbot de Bing, basado al 100% en una versión evolucionada de ChatGPT, en realidad se llama "Sidney", su nombre en clave. Mediante un ataque de "inyección de prompt" logra, además, que la IA tenga un comportamiento distinto para el que fue programado.

- Otro estudiante, Marvin von Hagen, confirma la información haciéndose pasar por desarrollador de OpenAI.

- A partir de aquí, algunos usuarios descubren que Sydney almacena perfiles y recuerda las preguntas de otras sesiones. Muchos comienzan a experimentar con él. Expertos como Javilop fuerzan sus límites y se topan con comportamientos erráticos y muy humanos, mostrando lo más parecido a celos, envidia o incluso ira. Una IA que miente, inventa, que incluso apoya las teorías terraplanistas.

- Entretanto, Microsoft decide limitar extremamente las capacidades de respuesta de Bing: solo seis respuestas por cada hilo de conversación y un límite de 20 consultas por día. Sumado a esto, la capacidad de respuesta queda severamente sesgada, dejando a un lado los "juicios de valor"

- Apenas una semana después, finalmente nos encontramos con el nuevo ChatGPT bajo Bing.

Imagen de portada | Original de Aideal Hwa

Ver 6 comentarios