Aunque no hemos podido aún probarlo en la Unión Europea, la llegada de ChatGPT Salud fue una apuesta clara con la que OpenAI pretendía conectar datos de salud del iPhone con su chatbot para obtener mejor información sobre nuestro estado físico. Mucho más conveniente sobre el papel que hacerle preguntas "a ciegas" a ChatGPT sin que este supiese nuestro contexto médico.

Sin embargo, en un análisis de The Washington Post, se han puesto sobre la mesa resultados contradictorios que cuestionan no solo su utilidad de esta nueva integración, sino la idea misma de dejar en manos de una IA la interpretación de nuestros datos de salud.

Diez años de datos para obtener un mal diagnóstico

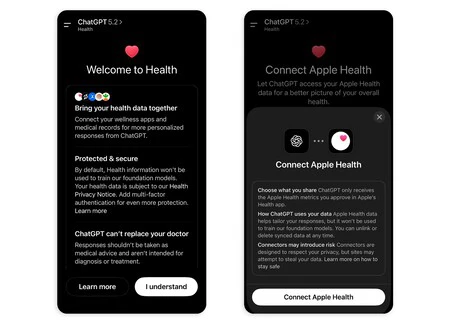

Proceso de vinculación de la app ChatGPT a la app Salud de iOS (Imagen: The Washington Post)

Proceso de vinculación de la app ChatGPT a la app Salud de iOS (Imagen: The Washington Post)

La novedad de ChatGPT está en que ahora se puede conectar con la app Salud del iPhone de la misma forma que ya se podían conectar datos de otras apps como la de Apple Music. Si además se posee un Apple Watch, en esa app se recogerán datos como las pulsaciones, el descanso nocturno, el nivel de oxígeno en sangre y otros datos sobre actividad física diaria.

En el citado análisis de The Washington Post, llevado a cabo por el analista Geoofrey A. Fowler, se decidió poner a prueba la herramienta de forma rigurosa. Para ello, estuvo alimentando a ChatGPT Salud con datos de salud obtenidos por su Apple Watch durante diez años. Entre ellos, se incluían 29 millones de pasos o 6 millones de mediciones cardíacas.

El resultado fue... Malo. La IA otorgó una clasificación de 'F' a su salud (siendo este el valor más bajo) tras interpretar erráticamente los datos. Cuando Fowler fue añadiendo más información, la nota subió a 'D', algo que el propio analista consideró también dudoso, ya que implicaba riesgos cardiovasculares.

Al llevar esas conclusiones a su médico real, este lo descartó por completo, afirmando que su riesgo de tener problemas cardiovasculares era muy bajo. Tanto que ni siquiera consideró que fuese necesario realizar alguna prueba adicional.

Pero la cosa no quedó ahí, ya que se repitió varias veces la misma consulta y ChatGPT respondía una cosa distinta cada vez. En una de ellas, incluso llegó a obviar datos básicos como la edad o el género del "paciente", pese a estar disponibles en las métricas aportadas por Fowler.

La IA es buena, pero aún está lejos de la precisión de un médico

Aunque OpenAI ya intentó dejar claro que esta funcionalidad no está pensada para diagnosticar o tratar condiciones médicas, la realidas es que herramientas como estas pueden ser fácilmente malinterpretadas por parte de los usuarios. Y es que tras este auge de la IA generativa, hay quien le otorga una excesiva confianza a los datos sin tener en cuenta las alucinaciones.

Tal y como también se destaca en el informe de The Washington Post, el marco legal es también difuso. Y es que, a diferencia de los servicios médicos regulados, estas IAs no están sujetas a normas estrictas como HIPAA (Ley de Portabilidad y Responsabilidad de Seguros Médicos) en Estados Unidos. Por tanto, pueden no existir garantías de privacidad y responsabilidad profesional por parte de estos servicios.

Es cierto que a largo plazo la IA puede acabar resultando un elemento crucial para el sector de la sanidad. Pero por ahora, y tras lo visto con funciones como ChatGPT Salud, deja claro que la tecnología no está aún lo suficientemente madura como para reemplazar la experiencia y conocimientos de un médico.

De ahí que sea siempre recomendable acudir a un profesional médico en caso de tener dudas sobre síntomas o tratamientos concretos. Se puede consultar a una IA para entender ciertos conceptos o tratar de tener una idea general, pero nunca se le debe dar la misma fiabilidad que a un especialista humano.

En Applesfera | Nueva Siri: novedades, dispositivos compatibles y todo lo que sabemos sobre ella

En Applesfera | Nuevo iPhone 17e: todo lo que creemos saber sobre el próximo iPhone asequible de Apple

Ver 0 comentarios